Jag tittade idag över några initiala samlingar av ett antal av Google 5-gram filerna jag lagt i ett antal kataloger motsvarande maximalt antal trådar. En bunt är klara. Helt säkert mestadels tämligen små-filer. Men åtminstone några stora är faktiskt klara. Jag lutar att låta det fortgå med det mindre än från början satt antal trådar som nu går (cirka tre stycken). Det stör föga undantaget mer sällan när BDB-databaser byggs om (vilket tycks vinna trots att de mer eller mindre löser hårddisk-accessen utan att jag åtminstone efter installation givit det särskilda rättigheter: Atomära koncept jag verkligen inte behöver ty jag skriver när jag bygger dem så står de statistiska diskret tid därefter - När Emacs fryser på auto-sav av några bytes vet man att en BDB synkroniserar slutligt mot disk för ej helt litet data).

Frågan är bara hur man ska få nytta av dem med tanke på att det så mycket mer praktiskt realistiskt ej ska kräva alla av filerna. En del användning finns naturligtvis men inget jag direkt upplever att jag inte redan har eller att det är inte troligt är jämförbart eller sämre för. Men tveklöst att det kan vara praktiskt att ha åtminstone när klart kompletterande en 80 MB - 100 MB titlar jag parsade ut mer än som här med en enklare optimerad version längre tillbaka (med fraser, relationer mellan fraserna, full intelligent POS-tagging så långt titel räcker till o.s.v.).

Men 100 MB är ju inte så mycket jämfört med alla 5-gram filerna. Cirka samman för färdiga filer ligger det troligen (om jag inte minns fel eller missade någon ev. egen output för första mängden som startades) cirka 800 MB inkluderande enkla fraser detekterade om NP resp. särskilt runt verb, IN och ett fåtal till, POS-taggarna, alla år, alla års resp. typer av frekvenser explicit, själva meningen och något mer jag inte just nu minns. Ej över 1 T helt säkert (jag frigjorde ungefär vid halva körningen ungefär 400 MB från partitionen det körde på från att då ligga på 30 MB fritt från innan 600 MB ledigt - samma partition som OS så jag tog och av det verkar några hundra gått åt nu - I min Linux får resurser jag startar ta vad helst de önskar relaterat CPU, minne och hårddisk så just OS-partitionen tror jag är klokt att vara försiktig med så man slipper bök att starta den från CD och städa upp bland filerna).

Minns inte exakt hur många de är. 400 kanske? Eller mindre? Och många på flera hundra MB styck. Bra ord börjande på ett par ovanliga bokstäver har mer föredömligt kortare filer.

Egentligen kunde man pröva dela ut den optimerade pos-taggern och några filer åtminstone när man kommer till tid när man från viktigare allokerar allt i datorerna längre tid och se om det kan ge några större filer.

I fortsättning av:

Relaterat initiala diskussionen ovan och parsade titlar tog jag ut och sparade traditionella mycket konservativa träd för resp. förutom övrigt mer praktiskt nära för mig i alla fall. Kanske kunde jag börja och dela en färdig fil och sedan varje gång Stanford eller någon annan - normaliserat deras storlek i head-count jfr mig - delar något jämförbart delar jag en till? Lite väl mycket Open Data åtminstone dagar jag vill ha internet-dator till nöjes-användning också kanske. Men om man nöjer sig med en stor så. En 300 MB kanske (den största av dom som körs nu kommer nog ligga där när klar om jag inte höftade till fel) ? Jag är exempelvis attraherad av ej små specialiserade ordlistor eller små-uppslagsböcker för forskningsområden eller särskilda kunskapsområden (inkl. mer konstnärliga eller kanske något praktiskt mekaniskt) där jag kan se värden men tvivlar på att det lär bli av att tagga ut någon av de fåtal jag har (sunt konverterade text-format).

På försök delade jag en fil. Tillsvidare i alla fall och som nästan är kutym är resp. fält tab-separerade ej dokumenterade. Lägger man inte överdrivet med tid bör de dock framgå. Vidare att kommentera finns också fraserna och linjära relationer från hur den förenklade snabbare POS-taggern arbetar. D.v.s. det ska normalt gå att direkt ta ut åtminstone motsvarande vad som i en mening (om det ev. varit det om ej här istället för fragment) medan vad som ej tycks görligt här om jag minns rätt kastas (om ej så kan jag ta och komplettera eventuellt hur man inser att POS-taggning ej ger ut NP-fras koncepten). Det var för mig bara NP som intresserade mig (relaterat viss dynamik adverb-adverb-adjektiv).

googlebooks-eng-all-5gram-20120701-mu

101 MB

https://drive.google.com/file/d/0B5IBnalBS0bxdmZxM2lCeVF1ZzQ/view?usp=sharing

Att jämföra med My jag lät bli att ladda upp ej heller brutalt stor men absolut inte liten heller (en av den större storleksgruppen där ingen färdig ännu inte blivit brutalt större styck för någon men så har jag inte startat något börjande på c ännu eller något på s, eller de verkligt stora filerna för 5-gram som börjar på a) på något mer än 300 MB.

Vad kan man få tillbaka av att dela data? Utmaningen man ej äger problemet för: Motivation och Verkshöjd / år

Längre tillbaka - på 1960-talet - kunde forskare inom språk sitta och räkna ut förhand (efter omfattande förarbete hålkort m.m.) dimensions-positionering av koncept. Normalisera dem relativt varande så att de kan ritas upp.

Idag är det väldigt vanligt att samma typ av forskare gör det. Men idag görs det med dataprogram givande fina illustrationer som dock typiskt säger ganska lite och som vanligen har positionerat många tusen koncept relativt varandra med mer tveksamma algoritmer man använda förr. Och så görs det i två-dimensioner idag.

Så klart kan man göra det i tre-dimensioner men komplexiteten är ordentligt värre där. Med dator. Att göra det förhand är minst sagt krävande annat än för ett fåtal. Möjligen att det kan vara värre än att beräkna planet-banorna. Nedan har vi några av en mängd liknande skisser jag råkat på från samma två författare lite varstans:

Större rymd över koncept relativt varandra från allmänt data. Motsvarande "attraktion" mellan koncepten utefter tre-dimensioner har räknats vidare från mätning människa propagerat och dimensionsreducerat.

Motsvarande men här från mätning individ vid en tidpunkt (ytterligare ett "mindre" antal - ej över fem som jag minns det - finns för andra tidpunkter så man kan följa förändringen). Här är det upplever jag mest visualiseringen och arbetet bakom datat som imponerar medan jag inte tycker att man ska tolka in något alls i det relaterat metod psykologi relativt individen. För en sak finns föga md den exakthet aktuellt här ens idag för en större population eller relaterat annan mer medicin förändring (och ej heller för personlighet, DSM m.m. heller om man försöker ta det direkt till metoder motsvarande aktuellt här. Aktuell del av de två böckerna resp. artiklar där motsvarande använt har mestadels använt för att illustrera metoden resp. anar jag varande ett "exempel-uttryck" för den större metoden "riktad" mot en väsentlig praktisk subkultur inom psykologi (motsvarande som Osgood kan jag tolka kanske också gjorde mot många inom språk, psykologi m.m.) eller lika gärna när metoden varande så ny blev allt mer känd uppmuntrades att paketera inriktade artiklar mot olika områden.

Ett mer ytlig mening kanske uppfattat längre ifrån psykologi var START resp. första konkreta resultatet Salt-1 (och SALT-1 gick i hamn ungefär samma år Osgood dog: Jag kan inte påstå att han här kände sig något så när nöjd med sina flera ganska imponerande arbeten relaterat attityder, språk m.m. och därmed kände sig redo och vila men jag tror att något att lära här kanske ändå finns: Rätt tänkt).

Och faktiskt att koncept rörande förtroende, distans konflikt, mening och betydelse vi lägger i symboler är vad jag kan se egentligen inte när man försöker skapa en till praktiskt tillämpning mot ett större problem är allt är distanserat alls. Jag har emellertid allmänt haft en del problem p.g.a. ålder och ovettiga priser att skapa en komplett samling och det jag särskilt har just rörande tillämpning atombomber och att förhandla kring det har jag inte tittat alls särskilt på: Det var mig okänt att jag hade dem där jag hittade det genom att söka atombomber för åren snarare än författaren. Det är atombomber: Förtroende och kraftfulla symboler - Adderar förstärkning i kontext nästan lite som adjektiv när de kraftigt modifierar ett näraliggande annars mer neutralt eller tråkigt noun. En av de första större politiska händelser jag minns var förhandlingarna mellan Reagan och Det Symboliska Ondskans Imperium denne ändå klarade att möta konstruktivt skapande för första gången under Kalla Kriget reducerad risk: Vi får se om Obama klarar det samma med Iran och om vi kanske närmaste åren ser en mer allmän positiv förändring i Iran reducerande det så problematiska teokratiska.

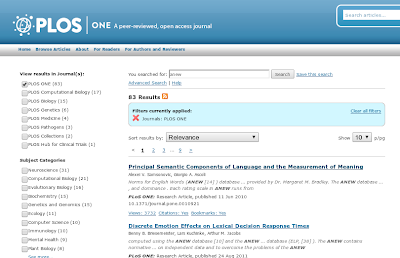

Jag ska undersöka om jag kan dela själva böckerna och artiklarna: Artiklarna är svåra att få fatt i men via antologier m.m. såväl elektroniskt från internet resp. inhandlande för normalt 10 kr - 25 kr är de lättare att få tag i (utan att betala något skämt-pris till journal-hus som i övrigt givit upp). Tills dess får man leta rätt på exempelvis The nature and measurement of meaning jag såg Google Scholar lågskattade till 14200 citat cirka (underskattande ett antal årtionden bakåt just p.g.a. sämre uttryckt på nätet idag). Google Books såg jag på sökning med strängen inom citationstecken gav cirka 10 000 träffar.

På många sätt tror jag att man lättare med dagens verktyg skulle få gedigna POS-taggade ordlistor från några tiotals år-sedan än idag. Och det säger jag som delvis formad av den kultur jag föddes in i även om jag många år försökt arbeta bort det (reward learning: Introducera kostnadsfria symboliska belöningar funktionella -> Vi har kul när vi arbetar! Att slutföra ett delsteg är belöning intränad till att motsvara mer förslappade nöjen också om jag får erkänna att nöjes-tittande på teve jag började med kanske tidigt 2012 eller sent 2011 är faktiskt mätbar kostnad och tror jag inte bara relaterad tid). Det kan i alla fall vara någon moraliskt normalitet att tänka utifrån när man reflekterar något lämpligt att POS-tagga och dela efter jag gjort det.

Sista versionen av Britannica är vad större folk förr hade delat en head-count normaliserad motsvarighet till att jag ev. delar ut Google 5-gram allt eftersom. Om de hade något bara lite närmare dagens dagens verktyg. De flesta ska tror jag se en rimligare ambitions-nivå och en gott steg nog uttryckande något av bättre kvaliteter än de flesta idag har. En avgränsad specialiserad liten ordlista eller uppslagsbok är gott arbete nog om deras särskilda format och struktur hanteras mer än att bara bara menings-fragment styckvis. Man kan se det som att för alla domäner utanför biomedicin (och besläktade områden) ska det färdiga resultatet börja ungefär där de största motsvarigheter man i övrigt hittar publicerade ofta relaterat artiklar eller små-mini-projekt vid universitet man sedan ej byggt vidare på utan övergivit (dålig uthållighet - Själva formen av symbolen att göra något mer än värdet, innehåll och att skapa något större krävande tid räcker för de flesta).

Copyright-frågorna delande ex. Britannica är dock redan lösta problem utredda med metoder konstruerade (whitening). Så just det är inte problemet. Knappast heller att man inte behöver hålkorta saker eller bara kan sampla ner det från deras sajt som html (och minns jag rätt fler format).

Målar jag världen idag sämre jämfört med några årtionden bakåt?

Det är förstår jag lätt att tycka att jag klagar "oblanserat". Saken här är emellertid att det just inte är obalanserat. Jag har sett nog av vad publicerat från 1960-talet till idag för dom här områdena för att kunna bedöma det utmärkt. Bara en sådan sak att enkla grund-metoder i algoritmer för analys knappast adderat något alls normalt använt. Dimensionsreduktion trots bättre alternativ görs fortfarande normalt med den enklare om än statistiskt tveksamma (latent semantic) som inte kom mycket senare som använd i området såväl sociologin som faktoranalysen. Vanligen görs den faktiskt med euklidiska avstånd för resp. distans nedanför trots såväl problem som lösningar relaterat det finns. Född in i dagens kultur och började här i vad man läser och lär tar det tag innan man riktigt ser detta och förstår det som mer eller mindre så illa det ibland verkar.

I koncept parsa text oavsett via statistik eller byggande små-träd står de bästa applikationerna oftast använda i vad de ger inte överdrivet längre ifrån vad väldigt tidiga skapelser inkluderande hålkort befann sig.

Sådant är nog delvis relaterat att bra skapelser tidigt är vad man sunt använder sökande andra värden. Någon mening att lösa samma problem flera gånger finns inte. Men relaterat dessa problem såväl som större koncept och modeller, data-representationer m.m. är också att annat än få har svårt att ta saker till något större över längre tid. Få upp det till mer än vad som tillför egentligen lite jämfört med mycket annat ungefär samma sak, förvalta och bygga vidare på det över längre tid o.s.v. Mer korta sämre relaterade uttryck som kanske är lättare att uttrycka ut (jag har inte försökt bedöma det) så att det märks utan att något större byggs över tiden. Andelen personer med värde de bygger över tiden meningsfullt att följa särskilt reduceras över åren. Och jag identifierar dessa personer ursprungligen typiskt aldrig först manuellt därför att jag söker generella problemområden som ungefär är relaterade problem jag har så får det sedan gå in i större artikel-representation så att man meningsfullt kan få ut vad man mer direkt behöver utan att själv behöva sitta och detalj läsa hundra tals artiklar innan man mot förmodan hittar något som ej igen löst samma problem p.s.s. som tusentals andra tidigare (och inte sällan sig själv av och till tidigare med något meningslöst väldigt begränsat nytt och lite omskriven artikel).

Så är det i engelska språkområdet. Min representation har fortfarande enormt bias mot Europa och USA med något bättre representation för Japan inom mindre områden (reward prediktion bl.a. där jag gillar preferens hos några där att använda de praktiskt lika fungerande logaritmiska formerna snarare än a / (b + cX) i vad dom kallar den hyperbola-formen). En grov approximation är emellertid att inget av värde i vettigt uttryckt storlek kultur är att förvänta från den arabiska världen under överskådlig framtid (de verkar upptagna med något annat). Mer sällan kan man hitta något intressant publicerat Sydafrika.

Kina utvecklas anmärkningsvärt snabbt: När man är van med annan nivå på motivationen

Kina märks dock kraftigt mer snabbt nu bara från journaler jag läser ytligt av och till direkt när de publiceras.

På MDPI (mycket rekommenderad som enkel väg för att få översikt över kreativitet i forskning över rekorderligt stor ämnes-bredd och av och till också mer tyngre sammanfattande artiklar från ett känt starkt koncept av känd person) var det var längre tillbaka inte en känsla av kinesiska namn - från Kina såväl som i relativ andel minskande andra länder - står för en allt större andel av det totala bidraget. Det har av och till funnits en kultur här där man är noggrann med detaljer särskilt i mening av att referera och utgå från välkända inarbetade namn vilket då fick en större relativ andel än annars normalt när de refereras eller andel där man utgår och bygger vidare från deras koncept. Detta var inte alls nödvändigtvis alltid dåligt per artikel där det åtminstone normalt distansierade sig mot mer standardmässig referens till något vedertaget koncept utan mening eller ens specifik relevans uttryckt för det egna arbetet.

Men i kreativ mening var det tecken på problematisk kultur. Och jag kan tacka min mer noggranna mindre kreativa sida för att jag ej skrev överdrivet tolkande från den här företeelsen även om jag kommenterade det några gånger med exempel. Ty detta tycks upplever jag i rent manuell upplevelse reducerats ordentligt nu. Sista två åren har inneburit förändring här.

Sådan förändring ska ej ses som relaterad statlig påverkan. Jag är emellertid rent praktiskt i värde per artikel inte odelat negativ till mer sådant i Kina än vi i här skulle finna normalt. Faktiskt har jag av och till fått ut konkret värde (är jag tämligen till mycket säker på) relaterat mycket konkreta intresse. Av och till har jag ju betraktat deras språkområde och kultur. I en icke moraliskt - eller praktiskt när det konkretiseras rörande sådant här ofta amoraliskt - finns av och till så att säga ett besläktat intresse rörande att följa och mäta en del saker. Det tenderar att indirekt - ibland tror jag ganska direkt faktiskt - komma ut via publicerade artiklar och arbeten (även om mer teoretiskt och när praktiskt ofta långt ifrån vad man kan spekulera kring om än oftare idag tycks för mig mindre distanserat som uttryckt i artiklar).

Och mitt subjektiva intryck är att det finns motivation drivande framåt här. Jag tror att kanske förklaringen - om jag har rätt - till hur det tidigare större fokus auktoriteter (kanske vad man kan jämföra med även om man ska akta sig för att ta person-känslor så direkt till större grupper via så sekundära såväl som "tråkiga" texter som journal-artiklar: Osäkerhet ännu lite ovan kanske publicerande så globalt såväl som vid hur man rätt balanserar mot kommunistpartiets ofta irrationella idéer kring ditt och datt där det kanske inte alls är görligt att först fråga om något är korrekt därför att det stänger möjligheten).

Ännu är de dock varken inom psykologi eller språk framme där dom amerikanska universiteten publicerar ut. Åtminstone för det engelska språkområdet och de journaler jag läser och tittar över ibland manuellt på nypublicerat. Säger jag att de är där om två år menar antagligen de flesta att jag har fel men jag tror det för områden som intresserar mig. Motiverade, asserting themselfs as good thinkers m.fl. labers man kan sätta på saker en förkärlek att förklara från relativ makt finns för. Färskhet ny information, nya impulser man ser färskt från omvärlden är emellertid också vad som stimulerar kreativitet (som ju ligger nära inlärning d.v.s. vad som när det går framåt - Vi har roligt när vi arbetar! där hjärnan lär sig lätt att motivera på - föder motivation vidare). Betänk också hårdvarusatsningar vi kan förvänta bör börja komma inarbetade som resurser tillgängliga i mening som börjar skapa praktiskt värde också här (så slipper man utilisera The Internet Walls routrar till att analysera sitt adverb-adverb-adjektiv data och kanske istället kan få färdiga slutsatser bättre tänkta än en själv: Skämtande men likväl uttryckande en sida av problematiskt möte forskning och diktatur).