Eftersom det "konkret" känns som att jag kan få en del nytta av studien diskuterad i inklusive. ev. två referenser (en jag ej sett indikerande något intressant och en jag vet är intressant men totalt glömt bort och ev. ej utnyttjar indikerat värde) ska jag för gott karma och också balansera läsarens bild av mig så att inte bara den fördomsfulla komikern ej främmande för att girigt glädja sig själv med vulgariteter bidrar jag har med ett enkel men mycket potent möjlighet för att kompensera för en av de största statistiska utmaningarna i lingvistik och data mining bredare.

Samtidigt för att inte bara visa upp den generösa själen som inte är rädd för att verka omanlig genom att dela med sig av sin kunskap och med kirurgisk exakt rocket-science skapa möjligheter för vanliga människor att lösa avancerade problem, är det viktigt att jag understryker det kalla affärssinne - likt vargskräcken innan elnätet kom bland mina konkurrenter eller "fiender" jag brukar kalla dem - genom att göra karma balansering på svenska istället för engelska och därmed utesluta de flesta läsare (kan gudinnorna och gudarna värdera ner dig för att du använder språket från landet där de lät dig födas? Knappast så jag lär få min karma belöning trots det) och genom att ge kunskapen som en bild så att den ej blir allt för enkelt tillgängligt för alla som söker information (människan är ett flockdjur och det är rimligt att anta att det också är gudinnans större plan med människan och därför att riktat bidra lite extra till den egna flocken bör även om det skulle visa sig felaktigt knappast när det är så pass rimligt minska karma-belöningen). Och som bonus för mina läsare visar jag i mötet mellan på en sidan av vågskålen (en vågskål jag med kompetent medmänskligt affärssinne sätter handen på för att alltid få vikterna att komma rätt) karma tillsammans med en spirituell balans där vi vågar ge och på den andra det evolutionärt riktiga mitt kallt-beräknande höggradigt effektiva sinne, tillsammans den moderna företagsledare världen idag söker både som problemlösare och förebild. Ett bonus-värde som bör förklaras för att alla ska förstå är att här skrämmer jag dessutom upp Google - särskilt medarbetarna med alla deras optioner som i ett feldrag av företagsledningen öppnat upp dem för denna typ av påverkan - genom att demonstrera vem som är alpha-male i deras kompetens område. De vet att om de springer över min fot kommer snart en kraftfullare sökmotor - kanske beskyddad genom en väpnad samling karma av rent av övernaturliga varelser - som klarar mer än 1-grams prediktion.

En utmärkt sammanfattad diskussion om problemområdet vi här ger en enkel lösning på finns i Foundations of Statistical Natural Language Processing. Ännu kortfattat gör språkets enorma flexibilitet och kreativitet att vi alltid lider svår brist på statistik om ord, koncept, deras relationer o.s.v. I lokala NGRAM på nivå samexistens i en mening är problemet för språk allmänt tämligen begränsat för varje person med tillgång internet och en modern dator.

När vi också behöver statistik om relationer mellan koncept på längre avstånd än några ord bort expanderar snabbt mängden data vi måste analysera. Sista försöket att uteslutande generera sådan statistik (typen P ( koncept A tillsammans med koncept B | kontext ) ) uteslutande från data som fanns lokalt på min dator inkluderade om jag minns rätt totalt 90 Giga byte data från bl.a. CiteSeer-X, flera av de journaler som publicerar fritt, Wikipedia och flera taxonomier och thesaurus i områden som kultur och geografi. Statistiken från den genereringen kastade jag bort därför att datamängden var ej tillräckligt för att ge ett värde jag inte redan hade.

Efter det för att bygga grund-plattform avseende statistik samlar jag istället in den direkt eller indirekt från närmare "allt" människan publicerar på nätet (faktisk metod är väldigt komplex inbegripande många frågeställningar att diskutera så jag avstår nu och helt säkert för all överskådlig framtid att diskutera hur jag gör förutom ett indikera en av ett större antal metoder eftersom jag tidigare nämnt den d.v.s. "indexeringen" av Department of Defence, USA, all publicerade forskning, rapporter m.m. tillgänglig på webben avseende nyckelord bedömt relevant). Samt ta in djupare statistik för avgränsade områden bedömda viktigare (ex. relaterat publicering av visuella uttryck som bilder, filmer, konst o.s.v.).

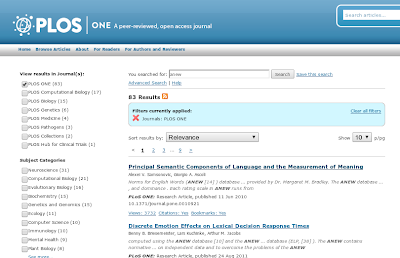

Nackdelen med sådan allmän statistik är den är optimal för att efterlikna den genomsnittliga människan. Inom specialistområden är den mindre bra. Metoden för att extremt mycket bättre dra nytta av denna statistik också för specialistområden finns kortfattat förklarad i bilden nedan (skärmdump av kod-kommentar). Klicka gärna på bilden för att läsa lösningen (punkt tre byggd från punkt två innan).

Genom att använda similarity där värderingen av feature relationer mellan ett koncept och andra koncept är utvalda från förståelse av kunskapsdrivna relationer (ej ett svårt problem p.s.s. rörande datakällor) och med värdering av features bland annat genom existerande P ( A | B ) statistik, tillsammans med ett intensitetsmått som korrekt värderar och skattar dom relationer vi utnyttjar (för att "skala" världen rätt så att säga mellan avbildningen i feature relations relativt statistik för co-occurance), får vi en praktiskt fungerande motsvarighet till P ( A | B ) vi kan använda på ungefär samma sätt med hög kvalitet för relationer vi annars hade saknat meningsfull statistik för. Värdet ligger ungefär på nivå att för områden välutvecklade i antalet feature relations klarar denna algoritm av att skatta P ( A | B ) värden i direkt frekvens på nivån att det inte behöver ligga mer fel än ofta cirka 2 gånger rätt svar (vilket kanske är ungefär felnivån för frekvensdatat ett steg åt vänster så att säga d.v.s. inverkande på första värdesiffran emedan normalt fel ligger i andra - i båda fallen när vi gör väldigt försiktigt konservativa datakvalitets bedömning).

En begränsning av metoden jag ej teoretiskt varit 100% säker på och därför själv på flera sätt försökt komma runt är att statistiken vi förstärker värdet av i specialistområden i "typ-form" behöver stämma med användningen. Är vi ex. intresserad på samexistens i ett kontext behöver det vara sådan statistik. Eller mer konkret för mina användningsområden har Google NGRAM där statistiken kommer från mycket lokala kontext nere på meningsnivå ett mycket begränsat värde (ett undantag finns från det som jag teoretiskt heller inte fullt förstår även om det mycket troligt är relaterat till konvergens per ord relaterat mening diskuterad i Ord som konvergerad mening: när varje koncept är 1-gram och relationerna mellan koncept vi söker är mycket nära normal thesaurus fungerar åtminstone 3- och 4-grams statistik utan hänsyn ordning och utnyttjande av hela ngrammen för statistik generering utmärkt när vi normaliserar för koncept existerande snarare än alla orden).

På samma tema som begränsningen av möjligheten att ta "lokal" NGRAM-statistik vidare ligger spekulativt en vad jag upplever sedan ett antal månader försämring av hur väl Google för specialistområden klarar att prediktera nästa ord i sökrutan (något jag använder väldigt ofta som del av hitta tillbaka till saker, rättstava, komma ihåg vad artiklar heter o.s.v.).

Möjligen kom den upplevda försämringen ungefär samtidigt som Google också blev konkret bättre på named entity recognition jfr exemplet nedan där de förstår att Department of Defence som sökord är samma sak som DoD i Common sense: Arkitektur.

Vad är problemet jag upplever med Google här? Att prediktionen övervärderar statistik från co-occurance i meningsbyggnad och lokala relationer på meningsnivå. Ev. har Google blivit bättre på detta men om så är det egentligen ingenting jag märkt då jag mer sällan söker på det sättet. Rättstavningen jag använder detta till också upplever jag var bra innan och är inte bättre på länge på något sätt jag märkt.

Däremot upplever jag mer säkert har istället prediktionen för sökordskombinationer när vi ligger närmare vad som motsvarar statistik av typen här diskuterat blivit sämre. Ex.

sökords-koncept från olika kunskapsområden men relevanta i något sammanhang, viktiga koncept från i näraliggande kunskapsområde höggradigt relevanta ex. för en forskningsartikel man söker hitta tillbaka till (ex. ett begrepp i titel tillsammans med en eller två samma eller motsvarande studiens taggar journalen publicerat den med)

En intressant fråga är om samma försämring också gäller samma typ av sökordskoncept men inom populärkultur (eftersom det där är givet att ordentligt med statistik direkt från sökningar finns). Det har jag ej kontrollerat. Ändå misstänker jag lätt att en delorsak till förändringen jag upplever är att Google värderat ner statistik från faktiska sökningar och tagit in NGRAM-statistik.

Ett förenklat exempel på tror jag samma problem som inför diskussionen om vad vi kan lära från det här bättre tydliggör har vi från när jag söker på ANEW. För 2-gram a new gäller att associationen mellan 1-gram a och new är enorm: vi skriver väldigt ofta a new. Att som Google direkt tolka om till a new (här utan kommentar ev. relaterat att de är så säkra på att jag skrivit fel eller att a tidigare hos Google var stopp-ord och fortfarande är det för en del men inte alla algoritmer) är dock helt fel eftersom vad jag söker efter heter just ANEW. Och det är dessutom vad jag sökt efter flera gånger och på bloggar identitets-bundna till samma konto jag söker med skrivit om medan jag aldrig sökt efter a new och såvida det inte är en populär film eller bok tvivlar jag på att särskilt många andra heller gör det. Ex. Plos One klarar dock utmärkt av sökningen.

Fotnot med kommentar till sökresultatet: Resultat tio är särskilt intressant: Constructions: a new theoretical approach to language. Så vitt jag såg avser artikeln ej något relevant ANEW men tycks ju åtminstone ligga nära i kompetensdomän. Gissningsvis speglar det att Google här använder statistik från mina tidigare site:edu sökningar eller sökningar bredare indikerande att sådan statistik ännu kanske bara får utrymme kompletterande på låga positioner ev. oftare när tvetydighet eller omtolkningar görs.

Att Plos ger relevanta sökresultat bör ej förklaras med deras som publicist flera världsledande journaler stora kunskapsbank relaterat forskning. Det ska här ej göra någon skillnad eftersom de publicerar fritt för alla att indexera samtidigt som det kontext vad de publicerar beskriver ligger mycket nära vad jag söker efter många gånger mer eller mindre dagligen.

Och för NGRAM-statistiken att de gått in i (menar en del t.ex. jag) myten om att NGRAM-statistik byggd över längre NGRAM ej adderar något värde. Längre NGRAM-statistik adderar ej värde enligt användning motsvarande beskriven i de studier som konstaterat att värde bottnat ut vid 5-gram och att värdet 5-gram ger framför 4-gram är ytterst begränsat. För hur folk namnger webbsidor, kombinerar sökordsområden o.s.v. är det dock givet att värde finns att hämta ordentligt för tydligt längre NGRAM också när tillämpningen primärt är som nu närmare meningsbyggnad. Jag inte tror men känner ibland att statistiken heller inte är 4-gram, och kanske att de ofta för att optimera och göra prediktionen väldigt snabb endast utnyttjar 1-gram och om algoritmen tror sig ha fått en tydlig träff nöjer sig med det. I så fall kanske problemen helt eller delvis har att göra med att man för flera sökordsområden faktisk inte i 1-gram och 2-gram kontext kan bedöma om prediktionen man där gjort är så pass tydlig att statistik från längre NGRAM ej behövs tillsammans med hänsyn till NGRAM-bakåt i sökord avseende samma sökning tillsammans med föregående närstående sökningar indikerande kontextuell domän (mest konkret när indikationer att användaren ej kommer rätt ändå uttrycka en ungefärlig mängd där tidigare sökningar troligt uttrycker relevant similarity i meningen att vi kan avgränsa i kontext och över flera förfrågningar dra slutsatser pekande mot vad som är rätt ungefär som named entity exemplet men i sökrutan istället för indexerade dokument och som slutsats skapad från ej lokalt data).

Frågan är vad motivet till förändringen är om orsaken ligger högre upp mer konceptuellt? Kanske att Google i så fall försöker optimera värdet all statistik för ord som lexem kan ge inom områden som ligger längre ifrån deras kärna (också i meningen att ex. deras anställda neurologiska experter kanske har mindre erfarenhet av språkanalys). Förutom Google NGRAM jag ej vill utesluta att de använder till sådant här kan det även gälla statistik som MRC Psycholinguistic Database eller ANEW (som välkända exempel men ej för ANEW rekommenderat utan åtminstone kombination med annat data och dimensionsförändring, och vidare gäller att deras mer begränsade publicering av datat gör att färre använder det vilket medför att kvalitetsproblem mer troligt kvarstår - jag känner själv till problem de från perspektivet psykologer ej insett att de gjort - jämförbara med vad som upptäckts i mycket annat liknande efter att de började att publiceras fritt). Personligen tror jag att det är ett misstag delvis relaterat vad som diskuterades i Abstrakta och konkreta koncept (diskussion: "The semantic richness of abstract concepts") rörande behovet av att transformera och/eller konvergera från ord till ett meningsfullt övergripande koncept för att klara att ta värde i ett dokument vidare ut från det (sökning i eller efter ett enskild dokument har ej varit ett svårt problem på flera år annat än för optimering av CPU, minne och hårddisk när budget är begränsad), också därför att jag sedan flera år har ett starkt bias mot att hellre se koncept - 1-gram, Ngram, bild, foto, konstverk, varumärke, byline... avser det samma sak är det lite av men inte exakt samma sak - oavsett representation snarare än ord:

"Att i sig utnyttja emotional potential eller för den delen egentligen allt tänkbart data som kan härledas från free-association norms m.m. liknande per ord statistik (se ex. MRC psycholinguistic database för ett antal trevligt samlade) är praktiskt för ex. nyhetsanalys väldigt meningslöst under förutsättning att vi ej också i motsatt riktning till hur övergripande mening påverkar lokal konvergens till mening kan göra en transformation av vad dessa samlat i ett kontext indikerar om tolkning och betydelse för den övergripande mening kontext konvergerar till (ett trivialt exempel kan vara vad en Wikipedia sida handlar om som mening övergripande kontext konvergerar till i betydelsen av hur vad som sägs på sidan påverkar läsarnas attityd, tolkning och förståelse av det övergripande konceptet).

Ett parallellt till både Blue Light Intensity och Emotional potential också använt är News Power som indikerar den emotionella tyngden (angenämt, otäckt m.m. i den dimensionen oavsett typ som ökar känslan i ett ämne eller en text), För alla tre (och många andra dimensioner också nödvändiga) görs just en transformation till övergripande koncept."

Kortfattat: Vilken mening med i ett visst situations-kontext "överför" ex. bilderna i en Wikipedia artikel till det koncept hela artikeln handlar om för personer i ett visst kultur-kontext och med vilken sannolikhet?

Hela den här diskussionen är ju dock uteslutande från mitt perspektiv. Vad som är optimalt för de flesta eller inte otroligt nästan alla användare av sökmotorer har jag ingen aning om. Och inte heller är detta särskilt viktigt för mig (jag är snarast mer "engagerad" - i modern jag bloggade om det en gång mening - i diverse inställningar Google inte klarar av att göra ex. addera Scholar bland övriga sökmöjligheter och göra gränssnitt från Scholar till övriga Google samma som för alla andra sökfunktioner istället för att de har kvar ett nu flera generationer äldre gränssnitt, sätta längre videoklipp som standard givet att jag aldrig annat än av misstag sökt på något annat m.m. liknande som mer regelmässigt stör mig av och till periodvis dagligen liksom att addera rankningsbelöning för att man tar sig tid och ger Google kritik och indikerar problem m.m. för att demonstrera att de välkomnar sådant och inte döljer bloggpostningar långt ner ex. här ge denna första platsen säg tre veckor på några viktiga sökord som Google, Statistik och Språk eller vad som nu bedöms relevant).

Relaterat

För den som vill lära mer om området eller oavsett kunskapsdomän helt enkelt inspireras av ett för bloggpublicering välgjort koncept inom Freedom och Knowledge Sharing inför ett eget projekt rekommenderas: