Det huvudsakliga syftet med sista "spindla efter strömmar" (när refererat rss-ström avses vilka som helst strömmar oavsett RSS eller ATOM resp. version) projektet var att öka mängden blogg-strömmar (och på vägen dit nyhets- / pressmeddelande-strömmar) på .edu-domäner eller övrigt inriktat forskning. Spindlingen utgick från alla pressmeddelanden publicerade på EurekAlert! fortfarande i Breaking News.

Robot dumpade hittade länkar tidigt i samma fil och längre fram när jag började tråda den i filer med slumpmässigt namn. Vidare sattes ett stopp-värde per domän parametriserat vid start d.v.s. vid varje återstart eller att tråden börjar om (för att slippa hålla mycket stora mängder länkar gjorda eller att göra) är det inte självklart att de länkar först skrivna till fil för en domän tas först utan ordningen ges av filerna sorterade efter namn.

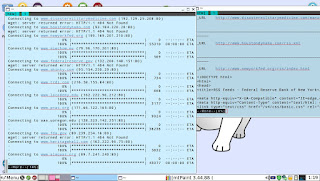

I skärmdump framgår ordningen filerna för redan besökta resp. identifierade länkar läses in. Rörande parametrisering anger första siffran antalet besök på domänen som tillåts, andra hur många länkar att besöka som tillåts ligga i minne (kan praktiskt hamna något under resp. över), tredje parametering vad som ska finnas i länken för att den ska besöka (eller tillåts resp. allt ska finnas) samt den fjärde ej i bilden omvänt från den tredje d.v.s. vad som ska uteslutas.

Utifrån tanken diskuterad i:

Införde jag möjlighet att parametrisera vilka undermängder av identifierade länkar en tråd ska prospektera. Bl.a. lät jag trådar gå tämligen länge (kanske 10 - 48 timmar totalt) för:

- Just Blogspot.

- Wordpress.com resp. Wordpress förekommande i url.

- Typepad.com

- .edu inkl. .edu.

- .gov inkl. .gov.

- .mil inkl. .mil.

- .org inkl. .org.

En relativt övrigt kortare tid men med vid den tidpunkten startad (sista 25% av tiden robotarna vandrade nätet) snabbt expanderande i antal hittade rss-strömmar: .com (minns jag rätt ej inkl. .com.).

Samma trådar efter att de kommit igång med att besöka tidigare identifierade länkar.

Exakt som jag förväntat från när jag skapade första proof-of-concept versionen av sökmotorn gäller att spindla efter RSS-strömmar är vekt inom flera områden med viktiga newsprovidera:

- Att utgå från <link ...> levererar ej och när det leverar en försvinnande liten andel.

Istället behöver man spindla efter länkade undersidor och där suga upp länkar (jag begränsade till länkar och intrycket är att det täcker upp de flesta även om några endast skriver dem i text) till RSS-strömmar man publicerar. Detta gäller särskilt:

- Amerikanska .gov och .mil sajter.

- P.s.s. som föregående en del nyhetstidningar.

Vidare besläktat men när man väl hittar motsvarande blogg fungerar ofta <link ...>:

- Bloggar som enskilda medarbetare, organisationer m.m. har "undangömda" långt in i spindlings-väg relativt endast enklast domän-namn.

I detta spindlings-projekt sökte jag endast <link ...> medan jag vid ett föregående också analyserade länkar för att söka avgöra om de ev. är RSS. Det första projektet gav ordentligt fler RSS-strömmar men införde också diverse felaktigt antaget RSS som ännu ej filtrerats bort (bl.a. en del sitemap-länkar).

Trots att .gov och .mil prioriterades i timmar blev andelen RSS-strömmar levererade försvinnande få och inte mer än cirka 10% av vad jag lade till manuellt genom att gå igenom de viktigaste sajterna (ex. resp. vapengrens huvudsida för .mil med ex. site-sökning med Google) , tjänsterna (ex. tjänster för varningar rörande väder - ex. tsnunami-alert - o.s.v.). Det understryker hur begränsat <link ...> är.

Riktad spindling mot URL inkluderande news och/eller press levererade vettigt och tämligen högt men prioriterades relativt ordentligt mindre än övrigt. Bäst resultat i antal identifierade strömmar gavs av självklara orsaker när Blogspot, Wordpress och Typepad prioriterades. Dessa prioriterades vidare ordentligt i tid utifrån tankarna diskuterade i:

Totalt tycks 147 172 RSS-strömmar identifierats. En del är antagligen defekta bl.a. av följande noterande orsaker:

- Angiven men används ej. D.v.s. man har växlat url någon gång men ej förändrat vad angivet alt. att den ej fungerar just när jag kontrollerat.

Den initiala start-noden EurekAlert! gav så länge jag körde en hög andel strömmar relaterade forskning. Men vilken andel det är av totalt identifierade domäner vet jag ej och har ej kontrollerat hur stort det totala antalet identifierade (spindlade eller inte) domäner är.

Trådar pollande RSS-strömmar. Den eller de parametriserade först inkl. EXTRA hämtar från vad som identifierats i diskuterad spidering. FAST särskilt prioriterade avseende bl.a. nyhetstjänster likt ex. Reuters eller New York Times (och dessutom inkluderade sådana manuellt adderade oavsett ofta uppdaterade). ALL avser en ganska stor lista skapad genom tidigare kontroll av alla sajter där det för mig är känt med ganska hög tillförlitlighet vilken entitet de tillhör (utnyttjande tvättat Wikipedia-data): totalt cirka 90 000 strömmar inkl. ett mindre antal (cirka 5000 - 20000) "defekta" strömmar och ATOM- och RSS-strömmar för samma publicering.

Sampling är e diskriminerande från annan aspekt än att det är önskvärt att en hög andel strömmar är på engelska. Och prioritet i manuellt arbete har gjorts för att söka inkludera särskilt politiska entiteter från länder "problematiska" att enkelt från domän identifiera som tillhörande ex. myndighet (ex. Sverige med government.se snarare än government.gov.se jag gärna önskat som synonym eller Japan med go.jp) liksom politiskt "mer bråkiga" länder som Ryssland och Kina. Vidare sker hantering sampling enligt principer som gör att ingen kostnad annat än i tid processing föreligger avseende att "inkludera för mycket" (undantag hantering strömmar där inlägg saknar meningsfull titel där positiv-särbehandling sker på ett antal RSS-strömmar från amerikanska myndigheter eftersom de där av och till berör varnings-tjänster vilka jag gärna vill få med just indexerade).

Spidering av url:er inkluderande news men ej .blogspot eller wordpress (därför de senare har egna trådar).

Sista raden ovanför ett antal = kan ge upp till två siffor indikerande antal länkar resp. antal strömmar identifierade.

Hur jag gärna vill se att domäner relaterat regering eller myndighet indikeras och p.s.s. relaterat utbildning med .edu..

Antal identifierade för några utvalda meningsfulla under-grupper

Totalt tycks 147 172 RSS-strömmar identifierats. Ev. summerar uppgifterna ej korrekt för undergrupperna vilket om så har att göra med logiken för hur resp. grupp tas ut när RSS-strömmarna efter spindling hämtas för att tas ned (typiskt enligt för ex. wordpress: index(lc($url),"wordpress") i Perl). Medan tillförlitlighet totalt andel är mycket god eftersom allt förekommande i filerna med identifierade RSS-strömmar tas in och lagras i hash-tabeller för att garantera unik-förekomst samtidigt som domäner som notoriskt indikerar både ATOM- och RSS-strömmar - ex. Blogspot.com - särbehandlas för att hantera detta).

Självklara blogg-plattformar

| Wordpress (Oftast Wordpress.com men allt inkl. wordpress i url-feed |

| 51190 |

|

|

| Feedburner |

| 1435 |

|

|

| Blogspot (extrahering utnyttjar Google's semantik för hur strömmar namnges men ej en perfekt lösning) |

| 46020 |

|

|

| Typepad (inkl. typepad i url feed) |

| 4219 |

Domäner indikerande meningsfull indelning verksamhet

| .edu (inkl. .edu.) |

| 4847 |

|

|

| .gov (inkl. .gov.) |

| 799 |

|

|

| .org (inkl. .org.) |

| 18179 |

|

|

| .com (inkl. .com.) |

| 21430 |

|

|

| .mil (inkl. .mil.) |

| 162 |

Övriga

| Alla övriga (ex. ip-adresser) |

| 3152 |